AI zamiga i przetłumaczy

Czy już wkrótce tłumaczyć na język migowy będzie korzystająca ze sztucznej inteligencji aplikacja w smartfonie? Paweł Potakowski z firmy Migam.org obiecuje, że tak. Czy w takim razie szykuje się rewolucja?

Mateusz Różański: Podobno już wkrótce zobaczymy awatara języka migowego. Co to za kolejny diabeł ze świata sztucznej inteligencji?

Paweł Potakowski: To żaden diabeł, to wręcz coś anielskiego i rewolucyjnego, a nie diabelskiego. Chociaż to, jak sformułowałeś pytanie, wpisuje się w sposób myślenia o sztucznej inteligencji. Z jednej strony obawiamy się i ją demonizujemy, myśląc, że ona może odebrać ludziom pracę, a z drugiej strony dostrzegamy to, jaki potencjał w niej drzemie. Sztuczna inteligencja daje nam możliwości, o których kiedyś mogliśmy tylko marzyć. Na przykład zastosowanie sztucznej inteligencji dla dostępności może przynieść olbrzymią jakościową zmianę. Choćby, jeśli chodzi o dostęp do informacji dla osób, które mają niepełnosprawność słuchu. Dobrych tłumaczy języka migowego jest po prostu za mało i nigdy nie będzie ich wystarczająco dużo. W Polsce Głuchych kulturowo mamy ponad 400 tys. osób, a na wojewódzkich listach, na które każdy może się wpisać, jest troszkę ponad 300 tłumaczy PJM. Dlatego, uprzedzając Twoje pytanie, sztuczna inteligencja nie będzie zagrożeniem dla dobrych tłumaczy, bo cały czas powstają nowe filmy, piosenki, audycje, które trzeba przetłumaczyć od zera. Zobacz, ile jest filmów czy seriali w bibliotekach Netflixa, Disney Plus etc. Tam jest masa treści i nie jesteśmy w stanie zapewnić przekładu dla każdej nowej treści, która powstaje w każdej sekundzie na całym świecie. Żeby to zrobić i żeby dać szansę Głuchym, by mieli faktycznie pełną dostępność do treści, do materiałów, niezbędna jest automatyzacja, oparta w tym wypadku na sztucznej inteligencji.

Ale jak to ma wyglądać w praktyce? Ostatnio zrobiłem się bardzo sceptyczny, jeśli chodzi o obietnice związane z AI.

Migam od 2013 roku pracuje nad automatyzacją tłumaczenia języka migowego. Jak mówił o tym nieraz Przemek Kuśmierek, prezes i założyciel naszej spółki, popełniliśmy bardzo dużo błędów i wiele razy uczyliśmy się, jak tego nie robić. Co więcej, zderzaliśmy się wielokrotnie z barierami natury technologicznej, bo kiedyś nie było, chociażby chmury obliczeniowej. Zdarzało się, że pierwsze urządzenia, na których pracowaliśmy, fizycznie potrafiły rozgrzewać się w takim stopniu, że parzyły w ręce. Nie dało się zrobić tego, co chcieliśmy w 2013 czy 2014 roku.

Natomiast ta rewolucja, którą można nazwać rewolucją Chata GPT, sprawiła, że ludziom otworzyły się oczy na możliwości sztucznej inteligencji i sieci neuronowych. Oczywiście AI była rozwijana od lat, ale dziś, dzięki działaniom firm takich jak np. NVIDIA, wykorzystując gigantyczną moc obliczeniową, może ona przynieść rewolucję w każdej dziedzinie życia. Również w sferze dostępności informacyjno-komunikacyjnej i tłumaczenia języka migowego. Co trzeba podkreślić, każdy niemal kraj i wiele grup etnicznych ma własny język migowy i my musieliśmy podjąć decyzję, który język będzie pierwszym, dla którego uruchomimy w pełni sprawnie działające narzędzia automatyzujące tłumaczenie.

I mnie osobiście jest naprawdę szkoda, że musieliśmy podjąć decyzję, że to nie Polski Język Migowy (PJM) będzie pierwszy, ale że z przyczyn praktycznych wybraliśmy Amerykański Język Migowy (ASL). Powód jest dosyć trywialny – amerykański rynek jest dojrzały i jest tam największa świadomość potencjału nowoczesnych technologii i gotowość na zastosowanie sztucznej inteligencji w tak niesamowicie ważnym obszarze. Do tego oczywiście dostęp do funduszy.

By sprostać temu zadaniu, stworzyliśmy zespół, który jest w stanie rozwiązać każdy problem. Mamy genialnych inżynierów, matematyków, technologów, programistów, ludzi, którzy znają się na swojej działce. Z drugiej strony Migam.org już od lat współtworzą Głusi, w tym Głusi językoznawcy. W naszym zespole ponad 40 procent to osoby niesłyszące. Ci wszyscy specjaliści od lat wkładają swoją olbrzymią wiedzę praktyczną, związaną właśnie z językiem migowym. Nad tym wszystkim czuwa wizjoner, Przemysław Kuśmierek, który nawet jak ktoś mu powie, że się „nie da”, to on mimo to zawsze znajdzie rozwiązanie.

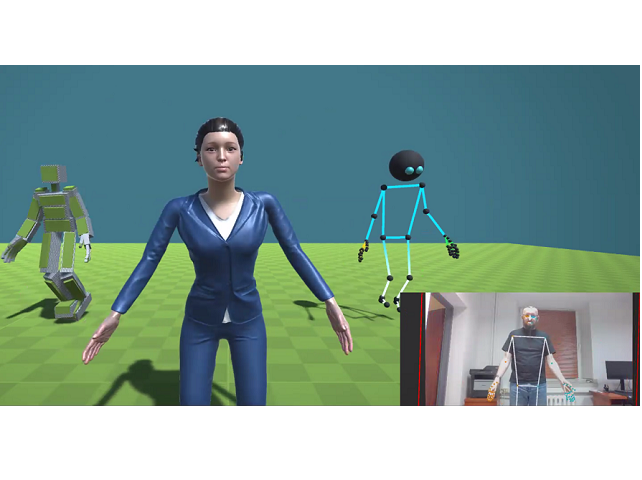

To wszystko przyniosło efekt w postaci działającego modelu sztucznej inteligencji, który jest w stanie samodzielnie, dzięki temu, jak został zaprojektowany, uczyć się dowolnego języka migowego, a następnie dzięki tej nauce, samodzielnie generować treści. Co najbardziej rewolucyjne, nasz model rozpoznaje obraz i z nagranych zwykłych filmów w dowolnym języku migowym, jest w stanie uczyć się tych treści, ale w taki sposób, by nie wykorzystywać wizerunku tłumacza. Pierwszy raz demonstrowaliśmy, to co zrobiliśmy w Kalifornii w połowie sierpnia 2024 roku. Wtedy podczas spotkania na Uniwersytecie Stanforda okazało się, że amerykańscy badacze, korzystający z finansowania m.in. od firmy Apple, nie byli w stanie zrobić tego, co nam się udało.

Czyli Migam Spółka Akcyjna pokonała w tym wyścigu Apple’a, jedną z największych technologicznych firm świata?

Łącząc kompetencje, których oni nie byli w stanie połączyć, bo jestem przekonany, że mieli bardzo mądrych ludzi znających się na swojej działce, ale zabrakło im takich fachowców od języka migowego. I polegli w zderzaniu się z problemami, które my już zidentyfikowaliśmy lata temu. Dlatego ojcowie technologiczni naszego projektu – Max Salamonowicz i Michał Pena osiągnęli z nami tak wiele w tak, krótkim czasie. MIGAM nad automatyzacją pracuje już przecież 11 lat.

To przejdźmy do konkretów – jak będzie wyglądał oferowany przez Was produkt?

Pierwszy produkt, który wprowadzamy na rynek, to będzie rozwiązanie, które pozwoli zaznaczyć tekst na stronie internetowej albo wprowadzić tekst na specjalnej stronie, służącej do komunikacji i otrzymać jego tłumaczenie w języku migowym w wykonaniu awatara, którego wygląd będzie można sobie wybrać.

Jednocześnie rozmawiamy z gigantami branży technologicznej i rozrywkowej, właśnie po to, żeby doprowadzić do tego, żeby w ich serwisach znalazło się automatycznie tłumaczenie na języki migowe. Zaczynamy od ASL - amerykańskiego migowego, ale to mogę już w tej chwili zdradzić, że trwają zaawansowane rozmowy z innymi krajami europejskimi. No i naprawdę liczę na to, że za jakiś czas będziemy mogli ogłosić, że ten awatar też będzie migał po polsku.

Nasz system sam uczy się z nagrań i rozpoznaje miganie. Nie ma więc żadnych przeszkód technologicznych, które stałyby na przeszkodzie, byśmy mogli tłumaczyć język migowy na wygenerowany głos czy tekst. Zapewnimy więc docelowo dwustronną komunikację, czyli coś, co było nie do osiągnięcia do tej pory.

Czym się w takim razie różni Wasz projekt związany z wykorzystaniem AI w tłumaczeniu języków migowych?

Bardzo wiele takich systemów czy projektów stricte naukowych, czy wstępnych projektów badawczych skupia się na tym, żeby znaleźć sposób na przedstawienie, zwizualizowanie jakiejś treści, ale we wcześniej ustalony sposób. My chcemy, by każda osoba niesłysząca docelowo była w stanie zamigać do kamery, a z drugiej strony ktoś usłyszy głos, który wypowie zamigane przez nią słowa. Już w tej chwili są na rynku smartfony firmy Samsung, (z którą od lat Migam współpracuje), które potrafią tłumaczyć rozmowy prowadzone w różnych językach. Proszę sobie wyobrazić podobną funkcjonalność dla osób Głuchych, na przykład na platformach takich jak ZOOM czy Teams. Oczywiście wymaga to odpowiedniego API do połączenia naszej sztucznej inteligencji z tymi platformami.

Czyli szykuje się po prostu ogromna, kosmiczna rewolucja i za parę lat problem braku dostępności do tłumaczenia języka migowego zniknie?

Ja wierzę, że nasze rozwiązania sprawi, że różnorodne treści łatwo będą dostępne dla osób Głuchych. Przy czym tłumacze nie stracą pracy, bo zawsze będą takie sytuacje, w których osoba niesłysząca będzie wolała, czy będzie potrzebowała obecności żywego człowieka. To mogą być rzeczy związane ze zdrowiem, czy ze swoją sytuacją prawną. Tam człowiek będzie wolał polegać na żywym tłumaczu. Dzięki naszej technologii tłumacze będą mogli skupić się na takich sprawach, a inne zostawią sztucznej inteligencji.

Nie jestem żadnym specjalistą od sztucznej inteligencji, ale trochę znam się na języku i wiem, że język stale się zmienia, zmienia się znaczenie poszczególnych słów etc. i nie obejdzie się bez „karmienia” Waszego systemu nowymi treściami.

Nasz model jest tak skonstruowany, by mógł się stale uczyć. Poza tym, że będzie znał podstawy języka migowego, które będą stanowiły tę podstawową pulę startową, będzie też doszkalany w zakresie specjalistycznych wariantów języka: medycznego, finansowego, stricte naukowego, żeby np. wspierać studentów niesłyszących w zdobywaniu wiedzy na uczelniach czy też badaczy, którzy zajmują się badaniem języka migowego. Takie wdrożenia i takie rozmowy też prowadzimy m.in. z polskimi uczelniami. Więc choć powiedziałem, że na razie jeszcze polskiego języka migowego nie będzie w naszym awatarze, to wierzę, że wkrótce to się zmieni.

Jeśli coś się zadziało w Stanach, zadziała prędzej czy później w Polsce. Jak sobie wyobrażasz wizytę osoby Głuchej w aptece w hipotetycznej przyszłości, gdy Wasza technologia będzie powszechnie dostępna?

W takiej sytuacji najpewniej ta osoba Głucha będzie miała u siebie na swoim smartfonie ultralekką wersję naszego systemu, bo w takich sytuacjach nie będzie potrzeby generowania hiperrealistycznego awatara. I kupując leki, osoba niesłysząca zamiga do swojego smartfona, a ten smartfon sam powie to, co zostało zamigane. I tak sobie to wyobrażam, że będzie w stanie pójść i załatwić praktycznie każdą dowolną rzecz. Co więcej, my już wstępnie testowaliśmy nasz model, tak zminimalizowany, bez wizualizacji głębokiej, hiperrealistycznej postaci. Wygląda na to, że będzie w stanie działać nawet offline, to znaczy, że nie będzie nawet musiał łączyć się z internetem.

W tym roku Nagroda Nobla z nauk ścisłych trafiła do specjalistów od AI. Sądzę, że jeśli, to o czym mi opowiadałeś stanie się rzeczywistością, to może nie Nobel, ale jakieś inne nagrody spadną na Was deszczem. No i oczywiście sytuacja osób Głuchych zmieni się diametralnie na lepsze.

Tego właśnie chcemy i to jest nasze marzenie, bo od lat angażujemy się w działalność, która może doprowadzić do zmiant tego świata na lepsze. Dlatego cieszę się, że mogliśmy o tym pogadać.

Dziękuję i życzę powodzenia!

Paweł Potakowski, specjalista ds. dostępności. Współpracuje z podmiotami publicznymi oraz biznesem. Z wykształcenia prawnik, z praktyki zawodowej marketingowiec. Pełniąc funkcję Dyrektora ds. Komunikacji (CCO) w MIGAM, Paweł otwiera świat dla osób niesłyszących poprzez innowacyjne rozwiązania komunikacyjne. Jako Prezes www.pracabezbarier.eu, aktywnie działa na rzecz usuwania barier w zatrudnieniu ludzi z niepełnosprawnościami, wprowadzając nowoczesne i skuteczne inicjatywy. Szkoli z dostępności, audytuje i certyfikuje, ale przede wszystkim naprawdę zmienia świat na lepsze pracując nad projektem avatara MIGAM.AI dla automatyzacji tłumaczenia języków migowych. Był jednym z uczestników tegorocznego Forum Dostępności.

Komentarze

brak komentarzy

![kadr z filmu My skrajnie otyli [FILM]](/files/nowe.niepelnosprawni.pl/public/2024/thumbnail_gajda_youtube_nowe.jpg)

Dodaj komentarz